Как корректно использовать файл robots.txt

Как корректно использовать файл robots.txt

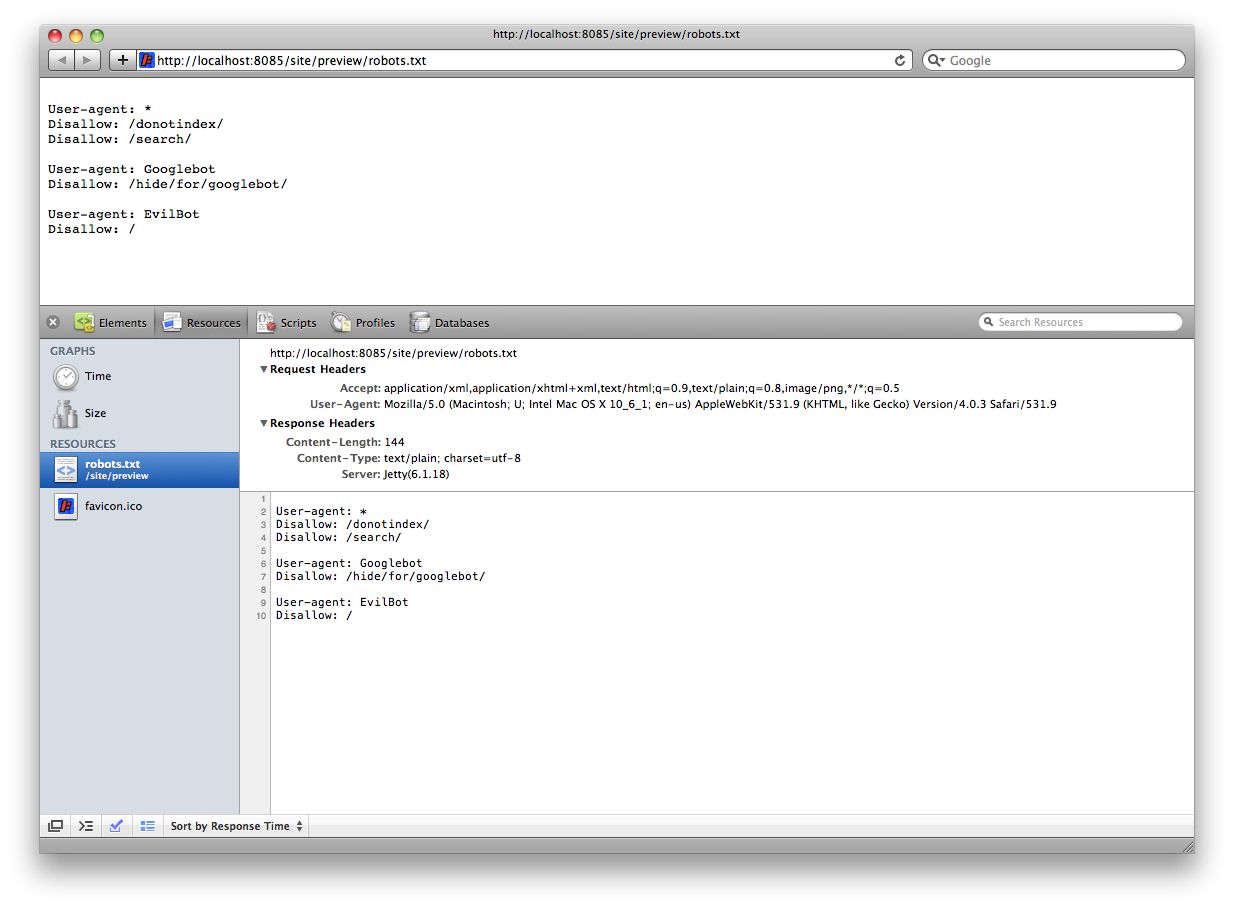

Некоторые считают, что robots.txt – это великое зло, которое приносит сайту много неприятностей. Однако иные придерживаются мнения, что robots.txt, может быть полезен своими свойствами. Стоит отметить, что в файле используются сразу несколько директив, многие из которых несут в себе положительные качества. Например, Host предназначен для указания основного хоста для поисковой системы Яндекс. Sitemap применяется, чтобы указать адрес карты сайта, а Crawl-Delay создан, чтобы указывать минимальную задержку между индексацией страниц.

Что такое robots.txt и какие проблемы встают при его использовании

Самая главная проблема, которая может встать на пути вебмастера – это файл robots txt, который находится в индексе страниц Google, но является закрытым. Многие специалисты на собственном опыте говорят о том, что если закрыть определенный раздел или конкретную страничку, то она не сможет оказаться в индексе (может и выпасть, но если она там уже существовала). На данный момент такая схема применима исключительно для поисковой системы Яндекс.

Файл robots используется Гуглом несколько иначе. Вообще, если начать разбираться в сущности данного явления, то можно обнаружить, что любой поисковик по данному запросу выдаст множество информации. Однако вебмастера со стажем скажут вам, что данный файл несет в себе не значение не добавлять страницы в индекс, а всего-навсего не сканировать ее. Любая страница может попасть в индекс, но при условии, что ссылка на нее находится внутри сайта.

Казалось бы, в этом нет ничего страшного, однако это не совсем так. Если страницы находятся в индексе, то в первую очередь, это напрямую сказывается на авторитете сайта. Кроме того, данный сниппет является фактором для снижения конверсии и снижает эффективность поведенческого фактора в поисковике. Если вы не желаете допустить такого, то лучше всего даже не пробовать использовать robot txt, а выбрать альтернативный вариант: внутренние средства Content Management System. В пользу этого говорит тот факт, что файл по совершенно разным причинам может быть просто недоступен, либо забыт или перенесен на другой сервер – вариантов множество. И именно по этим причинам даже то, что тщательно скрывалось, вмиг становится открытым. Кроме того, если беспорядочно закрывать все подряд, то ненароком можно спрятать и необходимое.

Возникает резонный вопрос: так лучше всего совсем не использовать файл robots? Не все так однозначно: иногда он может быть и полезен, особенно, если вы занимаетесь прописыванием зеркала для Яндекса.

Robots txt: пример удачного использования

- Лучше всего использовать данный файл, когда осуществляется создание или разработка сайта, и требуется его полное сокрытие. Это позволяет добиться того, что в индекс не попадет ничего лишнего.

- Файл может применяться, когда требуется скрыть сайт от посторонних поисковиков. К примеру, некоторым, исконно рунетовским, сайтам просто нет причин быть отображёнными в поисковой системе Yahoo!

- Robots может быть использован и в качестве средства для сокрытия некоторых приватных разделов сайта. К примеру, роботам незачем знать контактные данные, пароли и логины пользователей.

- Чтобы снизить нагрузку на сам сервер. Как правило, многие сетевые ресурсы содержат в себе фильтры, функционалы, работа которых требует усердной работы сервера. Если робот не будет иметь доступа к ним, автоматически нагрузка будет снижена.

Использовать или не использовать данный файл – это дело каждого. Для многих он может оказаться полезен, а кто-то будет разочарован.